Ley de Grosh

| ||||||

Ley de Grosch. Esta ley, que toma el nombre de Herbert Grosch, un astrónomo que trabajó en el Laboratorio Watson de IBM, señala que, al mismo tiempo que la capacidad de proceso de los chips ha ido aumentando año tras año (Primera Ley de Moore), sus precios han ido reduciéndose también de manera progresiva.

Sumario

Antecedentes de la Ley

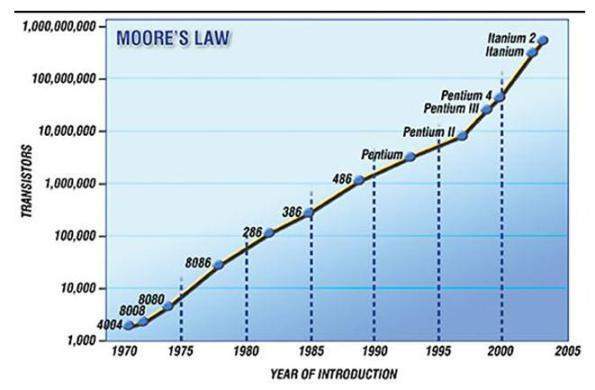

Con frecuencia se citan en conferencias, cursos y artículos, muchas “leyes” de la información, observaciones, algunas de ellas empíricas, sobre cómo evolucionan las tecnologías de la información, o sobre cómo utilizamos la información a nivel personal u organizacional. Quizás la decana, y también más conocida, es la “ley” de Moore, sobre la evolución de la densidad de transistores en un chip, así como, la “ley” de Grosch.

A principio de los 1960s el diseño de los computadores estaba enfrentando el límite de los rendimientos decrecientes. En ese tiempo la idea era dotar a las CPU de tantas instrucciones como fuera posible, para hacer programas lo más pequeños y eficientes en el uso de memoria. Esto, por supuesto, generaba computadores muy complejos, sobretodo en una era en que las CPUs se construían soldando transistores individuales a mano.

Una solución para problema, que se empezó a explorar en aquel tiempo, fue la sobreposición, que derivó en lo que conocemos actualmente como instruction pipelining, que permite que una CPU trabaje en pequeñas partes de varias instrucciones al mismo tiempo.

La otra solución al problema era la computación paralela: construir un computador a partir de un número de CPUs de propósito general. La idea es que el computador se encargue de mantener ocupadas a todas las CPUs, pidiéndole a cada una que trabaje en una pequeña parte del problema y después recolectando los resultados en la respuesta final.

Durante las últimas dos décadas se ha cumplido sistemáticamente la Ley de Moore, según la cual el número de transistores que de cada chip de silicio se duplica cada 18 meses, con lo que su capacidad de procesamiento y/o almacenamiento aumenta. Simultáneamente, se ha cumplido la Ley de Grosch, según la cual el precio de esos mismos chips se reduce a la mitad cada tres o cuatro años. Ambas leyes se han tenido en consideración en la implantación de mejoras prácticas de desarrollo de ingeniería de software hasta hoy día.

Curiosidad entre Ley de Moore y Ley de Grosch

La Ley de Moore fue formulada el mismo año 1965 que la Ley de Grosch.

En 1965. La revista Electronics Magazine cumplía 35 años, y le pidieron a Moore un artículo en el que predijera como sería la electrónica del futuro próximo, en unos 10 años. Moore se fijó en los circuitos integrados, que tenían por entonces 4 años de vida, y en su evolución hasta entonces. Observó que el número de transistores y resistencias estaba doblándose cada año. Así que eso mismo fue lo que predijo:

La Ley de Moore se suele citar mucho cuando se lanzan nuevos microprocesadores al mercado y que vale la pena conocer en profundidad. Ley de Grosch se suele citar:

.

Ha sido formulada la ley mediante la expresión:

C = 1/s1/2

donde C es el coste del procesador, y s es la velocidad del mismo. De esta forma, teniendo en cuenta que la Ley de Moore nos dice que la velocidad de los procesadores se duplica cada 18 meses, o cada 24, según cual sea la fuente consultada (o sea, se cuadriplica cada 3 o 4 años) los costes de procesamiento se reducen a la mitad cada 3 o 4 años.

Importancia de la Ley de Grosch

Hasta no hace mucho, "se llevaban" los sistemas centralizados. Durante años, la gente ha seguido el consejo del Dr. Herbert Grosch, que sostenía que cuanto mayor fuera el sistema, mayor sería la relación cantidad-precio. Conocida como la ley de Grosch, esta creencia imperó en la industria durante décadas.

Tanto así, la curva estadística que se ajusta es que el desempeño es proporcional a la raíz cuadrada del costo, la Ley de Grosch de 1965.

Por un lado, hoy en día la Ley de Grosch se considera una evidencia histórica de las percepciones equivocada que ha tenido la ciencia de la computación.

Por el otro, con el paso del tiempo, los microprocesadores irrumpieron en la era de la "casa de cristal", trayendo consigo mejoras del rendimiento y una drástica reducción en los costes del hardware que nos permitía empaquetar mucha potencia de proceso en servidores pequeños y distribuidos. Muchos pensaron que sería el final de la Ley de Grosch.

La computación distribuida se convirtió en la norma para muchos, que instalaron LANs PC y servidores distribuidos abarcando toda la empresa. Aunque este modelo sigue siendo adecuado para algunas compañías, hay muchas que están empezando a cuestionar el coste y la complejidad de gestionar sistemas distribuidos.

Ley de Grosch encajo bien en la tecnología mainframe de su tiempo y provocó que muchas organizaciones compraran una sola máquina, la más grande que pudieran conseguir. Con la tecnología del microprocesador, la ley de Grosh ya no es válida. Por unos cuantos cientos de dólares, es posible comprar un microcircuito de CPU que puede ejecutar más instrucciones por segundo que las que realizaba uno de los más grandes mainframes de 1980.

Observaciones

Hay decenas de leyes, enunciadas como las mencionadas aquí, si no centenares de tal tipo de observaciones, que no constituyen, en absoluto, “leyes” científicas, sino conclusiones derivadas de la observación repetida de situaciones, y para las que no se tienen aún una explicación razonable o razonada.

Fuentes

- Cornella A. Infoxicación:buscando un orden en la información. <http://www.infonomia.com>. Barcelona, 2010

- Como desarrollar software y no morir en el intento.http://helkyncoello.wordpress.com/2008/09/04/como-desarrollar-software-y-no-morir-en-el-intento/

- http://www.muyinteresante.es/ que-es-la-ley-de-moore

- http://petra.euitio.uniovi.es/~arrai/historia/trilobytes/ ley de Moore

- http://sistemasdeinformacionautomatizados.blogspot.com/2011/06/ la-ley-de-moore-concepto-tendencias