Mecánica cuántica

| ||||||

La mecánica cuántica es la parte de la física que estudia el movimiento de las partículas muy pequeñas. El concepto de partícula "muy pequeña" atiende al tamaño en el cual comienzan a notarse efectos como la imposibilidad de conocer con exactitud infinita y a la vez la posición y la velocidad de una partícula (véase Principio de indeterminación de Heisenberg), entre otros. A tales efectos suele denominárseles "efectos cuánticos". Así, la Mecánica cuántica es la que rige el movimiento de sistemas en los cuales los efectos cuánticos sean relevantes.

Sumario

La mecánica cuántica en las ciencias

En Física, la mecánica cuántica (conocida originalmente como mecánica ondulatoria)[1][2] es una de las ramas principales de la física, y uno de los más grandes avances del siglo veinte para el conocimiento humano, que explica el comportamiento de la Materia y de la Energía. Su aplicación ha hecho posible el descubrimiento y desarrollo de muchas tecnologías, como por ejemplo los transistores que se usan más que nada en la computación. La mecánica cuántica describe en su visión más ortodoxa, cómo cualquier sistema físico, y por lo tanto todo el Universo, existe en una diversa y variada multiplicidad de estados los cuales, habiendo sido organizados matemáticamente por los físicos, son denominados autoestados de vector y valor propio. De esta forma la mecánica cuántica explica y revela la existencia del Átomo y los misterios de la Estructura atómica; lo que por otra parte, la Física clásica, y más propiamente todavía la mecánica clásica, no podía explicar debidamente. De forma específica, se considera también mecánica cuántica, a la parte de ella misma que no incorpora la Relatividad en su formalismo, tan sólo como añadido mediante Teoría de perturbaciones. La parte de la mecánica cuántica que sí incorpora elementos relativistas de manera formal y con diversos problemas, es la Mecánica cuántica relativista o ya, de forma más exacta y potente, la Teoría cuántica de campos (que incluye a su vez a la Electrodinámica cuántica, Cromodinámica cuántica y Teoría electrodébil dentro del Modelo estándar) y más generalmente, la Teoría cuántica de campos en espacio-tiempo curvo. La única interacción que no se ha podido cuantificar ha sido la Interacción gravitatoria.

La mecánica cuántica es la base de los estudios del Átomo, los núcleos y las Partículas elementales (siendo ya necesario el tratamiento relativista), pero también en Teoría de la información, criptografía y Química.

Introducción

La mecánica cuántica es la última de las grandes ramas de la Física. Comienza a principios del siglo XX, en el momento en que dos de las teorías que intentaban explicar lo que nos rodea, la Ley de gravitación universal y la Teoría electromagnética clásica, se volvían insuficientes para explicar ciertos fenómenos. La teoría electromagnética generaba un problema cuando intentaba explicar la emisión de radiación de cualquier Objeto en equilibrio, llamada Radiación térmica, que es la que proviene de la vibración microscópica de las partículas que lo componen. Pues bien, usando las ecuaciones de la electrodinámica clásica, la energía que emitía esta radiación térmica daba Infinito si se suman todas las frecuencias que emitía el objeto, con ilógico resultado para los físicos.

Es en el seno de la Mecánica estadística donde nacen las ideas cuánticas en 1900. Al físico Max Planck se le ocurrió un truco matemático: que si en el proceso aritmético se sustituía la integral de esas frecuencias por una suma no continua se dejaba de obtener un infinito como resultado, con lo que eliminaba el problema y, además, el resultado obtenido concordaba con lo que después era medido. Fue Max Planck quien entonces enunció la hipótesis de que la radiación electromagnética es absorbida y emitida por la Materia en forma de Cuantos de luz o Fotones de energía mediante una constante estadística, que se denominó Constante de Planck. Su historia es inherente al Siglo XX, ya que la primera formulación cuántica de un fenómeno fue dada a conocer el 14 de diciembre de 1900 en una sesión de la Sociedad Física de la Academia de Ciencias de Berlín por el científico alemán Max Planck.

La idea de Planck hubiera quedado muchos años sólo como hipótesis si Albert Einstein no la hubiera retomado, proponiendo que la Luz, en ciertas circunstancias, se comporta como partículas de energía independientes (los cuantos de luz o fotones). Fue Albert Einstein quién completó en 1905 las correspondientes leyes de movimiento con lo que se conoce como Teoría especial de la relatividad, demostrando que el electromagnetismo era una teoría esencialmente no mecánica. Culminaba así lo que se ha dado en llamar Física clásica, es decir, la física no-cuántica. Usó este punto de vista llamado por él “heurístico”, para desarrollar su teoría del efecto fotoeléctrico, publicando esta hipótesis en 1905, lo que le valió el Premio Nobel de 1921. Esta hipótesis fue aplicada también para proponer una teoría sobre el Calor específico, es decir, la que resuelve cuál es la cantidad de calor necesaria para aumentar en una unidad la temperatura de la unidad de masa de un cuerpo.

El siguiente paso importante se dio hacia 1925, cuando Louis de Broglie propuso que cada partícula material tiene una Longitud de onda asociada, inversamente proporcional a su masa, (a la que llamó Momentum), y dada por su Velocidad. Poco tiempo después Erwin Schrödinger formuló una Ecuación de movimiento para las "ondas de materia", cuya existencia había propuesto de Broglie y varios experimentos sugerían eran reales.

La mecánica cuántica introduce una serie de hechos contraintuitivos que no aparecían en los paradigmas físicos anteriores; con ella se descubre que el mundo atómico no se comporta como esperaríamos. Los conceptos de incertidumbre, Indeterminación o Cuantización son introducidos por primera vez aquí. Además la mecánica cuántica es la teoría científica que ha proporcionado las predicciones experimentales más exactas hasta el momento, a pesar de estar sujeta a las probabilidades.

Desarrollo histórico

La teoría cuántica fue desarrollada en su forma básica a lo largo de la primera mitad del Siglo XX. El hecho de que la energía se intercambie de forma discreta se puso de relieve por hechos experimentales como los siguientes, inexplicables con las herramientas teóricas "anteriores" de la mecánica clásica o la electrodinámica:

- Espectro de la radiación del Cuerpo negro, resuelto por Max Planck con la cuantización de la energía. La energía total del cuerpo negro resultó que tomaba valores discretos más que continuos. Este fenómeno se llamó cuantización, y los intervalos posibles más pequeños entre los valores discretos son llamados quanta (singular: quantum, de la palabra latina para "cantidad", de ahí el nombre de mecánica cuántica). El tamaño de un cuanto es un valor fijo llamado constante de Planck, y que vale: 6.626 ×10-34 julios por segundo.

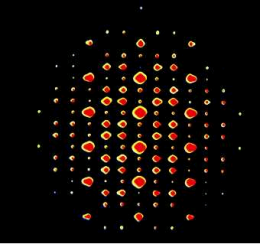

- Bajo ciertas condiciones experimentales, los objetos microscópicos como los Átomos o los electrones exhiben un comportamiento ondulatorio, como en la interferencia. Bajo otras condiciones, las mismas especies de objetos exhiben un comportamiento corpuscular, de partícula, ("partícula" quiere decir un objeto que puede ser localizado en una región concreta del espacio), como en la Dispersión de partículas. Este fenómeno se conoce como Dualidad onda-partícula.

- Las propiedades físicas de objetos con historias relacionadas pueden ser correlacionadas en una amplitud prohibida por cualquier teoría clásica, en una amplitud tal que sólo pueden ser descritos con precisión si nos referimos a ambos a la vez. Este fenómeno es llamado Entrelazamiento cuántico y la Desigualdad de Bell describe su diferencia con la correlación ordinaria. Las medidas de las violaciones de la desigualdad de Bell fueron de las mayores comprobaciones de la mecánica cuántica.

- Explicación del efecto fotoeléctrico, dada por Albert Einstein, en que volvió a aparecer esa "misteriosa" necesidad de cuantizar la energía.

- Efecto Compton.

El desarrollo formal de la teoría fue obra de los esfuerzos conjuntos de varios físicos y matemáticos de la época como Schrödinger, Heisenberg, Einstein, Dirac, Bohr y Von Neumann entre otros (la lista es larga). Algunos de los aspectos fundamentales de la teoría están siendo aún estudiados activamente. La mecánica cuántica ha sido también adoptada como la teoría subyacente a muchos campos de la física y la química, incluyendo la Física de la materia condensada, la Química cuántica y la Física de partículas.

La región de origen de la mecánica cuántica puede localizarse en la Europa central, en Alemania y Austria, y en el contexto histórico del primer tercio del Siglo XX.

Espectro de radiación del cuerpo negro

Cuando se estudia la radiación electromagnética producida por un cuerpo caliente común, se deben tener en cuenta los “errores introducidos” por la energía que éste refleja. Los físicos, a finales del siglo XIX, querían estudiar de qué forma era el espectro de radiación de un cuerpo que no reflejase energía; así pues, optaron por un cuerpo negro, que en teoría es capaz de absorber toda la energía suministrada.

Teóricamente un cuerpo con estas características, al calentarlo, emite luz (radiación electromagnética); esta luz aumenta poco a poco su longitud de onda a medida que el cuerpo se va haciendo más caliente, hasta el punto de llegar al espectro visible. Se disponía pues de dos leyes para predecir el comportamiento de un cuerpo en estas condiciones:

la primera es la ley de Stefan, la cual postula que el poder emisor de un cuerpo negro (la potencia, o lo que es igual: la cantidad de energía por segundo) es proporcional a la cuarta potencia de la temperatura; La segunda es la ley de Wien-Golitzin, la cual postula que al elevarse la temperatura del cuerpo negro, la longitud de onda correspondiente al máximo del espectro va haciéndose más pequeña, desplazándose hasta el violeta.

Con la primera ley no hay problema; pero la observaciones no concordaban con la segunda, pues a medida que la temperatura aumentaba, el máximo correspondiente a la longitud de onda se hacía azul y no violeta. Así pues, se trataron de unificar estas dos leyes y “repararlas”, este trabajo fue conseguido por los físicos Rayleigh y Jeans, pero esta nueva ley unificada tan sólo podía explicar la curva del espectro en los intervalos del amarillo y el naranja, pues para el violeta, el ultravioleta y longitudes más cortas predecía que la intensidad de la radiación crecía ilimitadamente, lo cual era absurdo. La física clásica entró en crisis.

Max Planck era uno de lo físicos que estaba tratando de explicar la curva del espectro obtenido. Aquél, a diferencia de otros colegas, optó por tratar de obtener la ecuación matemática de la curva experimental, y como un golpe de suerte la consiguió. Ahora planck tenía la ecuación que generaba la curva, pero éste se encontró en un callejón sin salida cuando trató de deducirla de las leyes de la termodinámica. Luego de agotadores días de trabajo, planck llegó a la conclusión de que con las leyes de la física clásica no era posible deducir la curva; sólo es posible si se asume que la energía no es emitida como un continuo sino como un conjunto de paquetes, a los que planck llamó cuantos. Estos paquetes no pueden tener energías arbitrarias, sólo pueden tener múltiplos enteros de una constante (constante de planck); además, la energía radiada por un oscilador depende de su frecuencia de oscilación (no de la amplitud). La hipótesis cuántica de planck se resume en la siguiente ecuación:

E=hf donde h es la constante de planck que vale 6,55*10^-34 j.s , y f es la frecuencia

Así pues, nace la teoría cuántica y caen dos supuestos clásicos : la energía no depende de la amplitud sino de la frecuencia, y la energía no se radia como un continuo sino como un conjunto de paquetes discretos. Planck, luego de su hipótesis cuántica, no fue tomado muy en serio, pues ni él mismo era capaz de explicar algunas implicaciones que esta hipótesis conllevaba. Sólo fue hasta que Einstein logró aplicarla que todo empezó a tornarse más claro.

El efecto fotoeléctrico

Hacia 1899, el físico Lenard demostró que los rayos catódicos(electrones) pueden producirse mediante la iluminación de una superficie metálica dispuesta en el vacío, y descubrió algunos hechos interesantes: La cantidad de electrones desprendidos del metal depende de la intensidad; la velocidad de los electrones desprendidos no depende de la intensidad sino de la frecuencia del haz; y para cada metal existe un valor mínimo de frecuencia por debajo del cual no hay emisión de electrones. Este fenómeno no había podido ser explicado hasta la fecha; sólo un loco como Einstein, con su gran imaginación, era capaz de revivir la teoría corpuscular de la luz (de Newton) cuando se daba por hecho su naturaleza ondulatoria.

Einstein aplicó la hipótesis cuántica de planck para explicar el fenómeno de desprendimiento de electrones por un haz de luz (conocido como efecto fotoeléctrico); según Einstein, no era posible dar una explicación a este fenómeno si se asumía la luz como una onda, había que darle pues una naturaleza corpuscular; a estos corpúsculos Einstein los llamo fotones, y explicó con ellos los fenómenos detectados por Lenard:

Los electrones de los átomos del metal sólo pueden absorber ciertos valores de energía, múltiplos de un valor fundamental hf, es decir: la energía que absorben los electrones debe estar cuantificada. Por esta razón, la luz debe venir en paquetes que los electrones puedan absorber, y por esta razón, también, es que los metales no emiten electrones por debajo de un cierto valor de frecuencia, pues a los electrones sólo les “gustan” paquetes específicos. Como la energía es proporcional a la frecuencia (E=hf) y no a la intensidad, es por esta razón que las frecuencias más altas arrancan los electrones más veloces. Y debido a que mientras mayor sea la intensidad hay más fotones “golpeando” electrones, la cantidad de estos que se emiten depende de aquella. Einstein recibió el premio Nobel en 1921 por este trabajo. Ecuación del efecto fotoeléctrico:

Ec=h.f-w

Ec: energía cinética del electrón desprendido; f: frecuencia; h: cte planck; w:(función de trabajo)energía mínima requerida por un electrón para ser desprendido.

Funbral= w/h

F: frecuencia mínima para desprender el electrón

Los valores F y w dependen del metal.

El átomo de Bohr

Hacia 1911, por medio de un experimento de dispersión de partículas en metales, Rutherford descubrió que el átomo contenía una estructura interna, y que no era como la “sandía” que Thomson había propuesto. Según Rutherford, el átomo estaba compuesto por un núcleo cargado positivamente, y un exterior compuesto por electrones (negativos); la suma de las cargas de los electrones era igual a la carga del núcleo (y se conseguía la neutralidad del átomo).

Para que los electrones no cayeran al núcleo debido a la fuerza eléctrica, era necesario que éstos giraran, y así su fuerza centrífuga fuera igual a la fuerza de atracción eléctrica, para evitar el colapso del átomo; pero este movimiento por ser curvado generaba una aceleración, y según la teoría de Maxwell éstos deberían emitir radiación, lo que generaba que perdieran energía, y por ende se precipitaran en espiral hacia el núcleo. Así pues, con las teorías y las leyes de que se disponía no era posible explicar la estabilidad del átomo, como también el fenómeno de las líneas espectrales “perfectas” de una sustancia pura. Niels Bohr, en 1913, introdujo un nuevo modelo atómico, el cual combinaba tanto ideas clásicas como cuánticas; su trabajo se basó, generalmente, en introducir la constante de Planck al modelo matemático que representaba al átomo. Asumiendo el átomo como un sistema solar en miniatura, las ideas de Bohr fueron: Las órbitas de los electrones en el interior del átomo no son todas estables; de aquí se sigue que el electrón sólo puede estar en órbitas definidas (a determinadas distancias del átomo). Esto debido a que cada órbita representa un nivel de energía para el electrón, pero el electrón no puede tomar cualquier valor de energía, sólo hf ; siendo el nivel uno correspondiente al valor de energía uno, el nivel dos al dos....Los niveles aumentan de adentro hacia afuera; al nivel uno se le llama estado fundamental, y el electrón no puede bajar de este estado, pues no hay órbitas mas bajas que uno (los valores son enteros positivos).

Cuando el electrón se encuentra en una órbita estable, éste no emite energía, sólo emite o absorbe energía cuando salta de una órbita a otra. Como el electrón no puede emitir valores arbitrarios y continuos de energía en una órbita estable, no se cumple la predicción electromagnética, el electrón sólo emite valores enteros de energía; esta emisión cuantificada sólo se da cuando el electrón salta de una órbita o nivel de energía mayor a uno menor, la emisión es un fotón, exactamente con la energía que el electrón necesito para pasar de un estado menor a uno mayor; también se da el caso contrario: para hacer subir a un electrón de órbita o nivel, se necesita exactamente la energía de diferencia entre las dos órbitas o niveles, y el electrón permanece allí durante un tiempo (se dice: exitado) hasta que cae otra vez a la órbita o nivel original, y devuelve la misma energía que le fue suministrada en un comienzo (es devuelta en forma de un fotón).

Mediante estas ideas, Bohr explicó las líneas aparecidas en el espectro del átomo más sencillo, el hidrógeno; estas líneas eran muy bien definidas, y esto debido a que los electrones al ser excitados (con la energía exacta), saltaban a órbitas mayores que luego abandonaban, devolviendo la energía en forma de fotones con frecuencias muy específicas; estos fotones componían las líneas espectrales. Para cada elemento las líneas eran distintas, pues lo átomos también lo eran.

Esta interpretación, aunque errónea (pues luego fue tumbada por la mecánica ondulatoria) , fue capaz de dar una explicación satisfactoria, bonita y acorde con lo observado con relación a los espectros atómicos y a la paradoja del “átomo de emisión continua”.

La verdadera importancia de esta explicación, es que todos los científicos de la época se estaban convenciendo de que la teoría cuántica (o mecánica cuántica), era una potente y única herramienta para explicar el mundo de lo muy pequeño: el mundo de lo atómico.

Principio de complementariedad

Aunque Einstein ya estaba convencido de la existencia de los fotones, se necesitaba la prueba experimental que corroborara esta teoría. Compton desde 1913, venía trabajando con rayos x y su interacción con los electrones; aquél había descubierto que cuando un fotón golpea a un electrón, éste gana momento y energía hf, pero el fotón que ha entregado parte de su energía, disminuye su frecuencia (este fenómeno es conocido como dispersión o efecto Compton).

Para poder lograr una descripción de este fenómeno, Compton tuvo que asumir que los rayos x eran fotones muy energéticos (corroborando la teoría de Einstein), pero para dar una descripción completa de este fenómeno no sólo bastaba con introducir la teoría corpuscular de la luz, sino también la ondulatoria. Resultaban pues, dos teorías de la luz: la ondulatoria y la corpuscular, ambas correctas. Esta dualidad onda-partícula de la luz fue a lo que Bohr llamó “principio de complementariedad”, y se basa en que las teorías corpuscular y ondulatoria de la luz no se excluyen sino que se complementan, para así lograr una correcta descripción de la realidad. La luz es pues onda y partículas.

Dualidad onda-partícula

El descubrimiento de la dualidad de la luz dejó inquieto a Louis de Broglie, un físico de la época, que se preguntó: “si la luz también se comporta como partículas ¿por qué no se deberían comportar los electrones también como ondas?” A los electrones sólo se les puede asociar números enteros de órbitas y energías, y esto es algo propio en los fenómenos de vibración en ondas. De Broglie le dio una estructura matemática a su hipótesis asociándole una longitud de onda a los electrones o cualquier cuerpo material:

λ = h/mv

mv: masa y velocidad del cuerpo; h: constante de Planck

Así pues, si los electrones tenían propiedades ondulatorias, deberían presentar fenómenos de difracción. La longitud de onda asociada al electrón es de unos 10^-7cm; para difractarlo se necesita que éste pase por un espacio del orden de esta longitud. Hacia 1922 y 1923 los físicos Clinton Dawisson y Charles Kunsman habían estudiado el comportamiento de los electrones al ser dispersados por cristales; de Broglie, al enterarse, los disuadió para que realizaran el experimento, y en 1925 se publicaron los resultados que corroboraban la teoría de de Broglie. Pero el mundo científico era muy escéptico, más aún cuando se trataba de la teoría de un joven de 21 años.

Sólo fue hasta que Erwin Schrödinger formuló una teoría atómica con las ideas de de Broglie, que los físicos empezaron a revaluar las ideas sobre el electrón. En 1927 fueron publicados los resultados de nuevos experimentos, y fue comprobada la hipótesis de de Broglie.

El total desprendimiento con la física clásica, fue cuando se comprobó que no sólo los electrones y los fotones tienen esta dualidad onda-partícula sino también todas las demás partículas existentes.

Un macro cuerpo también tiene estas propiedades, pero su longitud de onda es tan ínfima que no puede detectarse. De Broglie, no interpretó muy bien este resultado, pues según él el electrón era como un bote viajando por una ola. Luego Max Born y [[[Heisemberg]]explicaron esta propiedad ondulatoria como la probabilidad de encontrar al electrón en un punto dado.

El principio de incertidumbre

Supongamos que queremos conocer la velocidad y la posición de una partícula, para lo cual es necesario una fuente de luz cuya longitud de onda sea igual o menor al tamaño de dicha partícula; luz con esta característica son los rayos gamma. Así pues, disparamos una haz de rayos gamma hacia la partícula, este rayo gamma va a “rebotar” (dispersarse) en la partícula (este rayo dispersado va hacia un detector para conocer algo sobre esa partícula), pero por efecto Compton este fotón gamma va a suministrar energía a la partícula y por ende, ésta se va a “perder” pues se le ha dado un golpe muy fuerte; así pues, vamos a tener algo de certeza sobre la velocidad pero casi ninguna sobre su posición. Ahora bien, supongamos que la partícula está en reposo (velocidad 0),si se sigue el mismo procedimiento anterior, cuando el fotón golpee a la partícula, ésta, de nuevo va ha perderse y no podremos saber algo sobre su posición. Werner Heisemberg, un precoz físico de la época y uno de los grandes estructuradores de la mecánica cuántica (desarrollo el método matricial de ésta), dedujo de las ecuaciones de la mecánica cuántica la conocida relación de incertidumbre en 1927, que en honor a Heisemberg fue llamado el principio de incertidumbre de Heisemberg. Las dos relaciones son:

Δp.Δx ≥ h

Δp: incertidumbre (Inexactitud) sobre el momento; Δx: incertidumbre (inexactitud) sobre la posición h: constante de planck

ΔE.Δt ≥ h

ΔE: incertidumbre (inexactitud) sobre la energía; Δt: incertidumbre (inexactitud) sobre el tiempo; h: constante de planck

Así pues, mientras con más precisión se quiera saber la velocidad (o momento) de un cuerpo, más es la incertidumbre que se tiene sobre su posición. Así mismo, mientras con más precisión se quiera saber la energía de un cuerpo más incertidumbre se tendrá sobre la medida del tiempo.

El principio de incertidumbre es uno de los peldaños más estables e importantes de la mecánica cuántica. Hay que aclarar que la incertidumbre no se condiciona al aparato de medida, la incertidumbre es una propiedad intrínseca en la naturaleza.

La antimateria

Paul Dirac, un físico de la época (Dirac fue a la mecánica cuántica como Newton fue a la física clásica), trató de obtener una versión relativista de la mecánica cuántica. Según la ecuación de Einstein para la energía de una partícula de masa m y momento p se tiene:

E²=m²c^2 + p²c² y esta formula se reduce a E=mc² cuando el momento es cero.

Pero al calcular esta energía se obtiene el resultado de una raíz, es decir: se obtienen valores -mc² y +mc². Dirac no se detuvo aquí. Cuando se obtienen los niveles de energía de la versión relativista de la mecánica cuántica resultan conjuntos positivos y negativos; el mayor nivel negativo es menor al menor nivel positivo; según la teoría atómica, el electrón debe caer al nivel más bajo ¿por qué entonces no caían todos los electrones al nivel negativo? porque ya estaban llenos. Si ya había electrones allí ¿por qué no suministrarles la energía necesaria para que saltaran a un nivel positivo?

Para que un electrón salte de un peldaño -mc² a uno +mc² se necesita energía 2mc², que para el electrón es aproximadamente 1 Mev (la energía de un rayo gamma aprox). El electrón creado es común y corriente, pero habrá dejado un hueco en el conjunto negativo; un hueco como estos deberá comportarse como una partícula cargada positivamente y con la misma masa del electrón. Dirac afirmo erróneamente que esta partícula era el protón a finales de los años 20. Pero un científico llamado Carl Anderson descubrió por accidente, en un experimento de rayos cósmicos, una partícula con la misma masa del electrón pero de carga positiva. Esta partícula fue llamada positrón.

Luego se fueron descubriendo más antipartículas asociadas a partículas específicas, lo cual llegó a la conclusión que toda partícula creada genera una antipartícula (cualquier partícula tiene asociada una antipartícula).

Interpretaciones

La interpretación de Copenhague

Para muchos físicos de la época el principio de incertidumbre fue una habitación oscura en la cual no se podía caminar con seguridad; sin embargo para unos cuantos, fue la pieza que faltaba para que todo el sistema fuera completo y coherente. Bohr fue uno de estos hombres, y en 1927 en una conferencia en Italia presentó la idea de complementariedad, y lo que es conocido como interpretación de Copenhague.

Bohr señaló que mientras en la física clásica un sistema puede considerarse como un mecanismo de relojería, en mecánica cuántica el observador interactúa con el sistema, haciendo que el último pueda considerarse como algo no independiente: si se realiza un experimento para medir la posición de una partícula se la obliga a que halla incertidumbre en su velocidad, y si lo que se obtiene no es la posición sino su velocidad, se la obliga a que halla incertidumbre en su posición, luego el observador hace parte del experimento y la mera detección lo modifica todo; el primero de estos experimentos muestra las propiedades corpusculares del sistema, mientras que el segundo muestra las propiedades ondulatorias del mismo; así pues, nunca, mediante un experimento podrán conocerse las propiedades corpusculares y ondulatorias de un sistema a la vez (se dice que la relatividad es una teoría clásica puesto que permite conocer posición y velocidad en el espacio-tiempo a la vez).

Toda la información sobre el sistema la proporciona el experimento, y como el observador ha intervenido en éste, no puede decirse algo sobre el comportamiento de este sistema cuando no se lo observa, sólo pueden obtenerse las probabilidades de que un suceso se dé; por ejemplo, los saltos cuánticos en el átomo son una interpretación de por qué se obtienen dos resultados diferentes del mismo experimento, no pude saberse que hay entre salto y salto; No se tiene ni idea de lo que hace una partícula cuando no se la observa, entonces podría decirse que no existe mientras no se la observe; el núcleo atómico no existe, no existen las partículas: “nada es real”.

Richard Feynman, uno de los desarrolladores de la electrodinámica cuántica, presentó, por medio de un experimento imaginario, algunas implicaciones a las que se llegaría con la interpretación de Bohr:

si realizáramos el experimento de la rendija, con el que Yuog demostró las propiedades ondulatorias de la luz, usando partículas, los patrones de interferencia nos llevarían a deducir las propiedades ondulatorias de éstas. Cuando se trata de una onda, como una ola por ejemplo, esta onda pasa por los dos agujeros de difracción, pero si hablamos de partículas como electrones o fotones ¿cuál partícula pasa por cuál agujero? Imaginemos un montaje en el que se tiene la rejilla de difracción, un detector de partículas (de electrones por ejemplo) y un cañón de partículas.

Asumamos electrones: el cañón se pone en funcionamiento, los electrones pasan a través de la rejilla y producen patrones de interferencia; Ahora bien, si reducimos la cantidad de electrones disparados por segundo de forma que sólo uno pase por la rejilla, este electrón produce patrones de interferencia, pero ¿por dónde pasó el electrón? ¿por cuál de los dos agujeros? Si tapamos uno de los dos agujeros el electrón no produce interferencia, y si colocáramos un detector en los agujeros para saber por dónde pasa el electrón tampoco se obtendría la interferencia (ocurriría lo mismo si no es uno sino varios los electrones); entonces ¿sabe el electrón desde un principio que están intentando detectarlo? “Sí”. Bien, entonces engañemos al electrón ¿cómo? Cuando sea disparado tapemos un agujero. Aún así, el electrón no produce interferencia ¿Qué está pasando entonces?

Cuando tratamos de detectar el electrón estamos interviniendo en él buscando saber su posición, lo que significa que este electrón muestre propiedades corpusculares (y halla incertidumbre en su velocidad), se “materialice” y no halla interferencia; tapar un agujero o saber por dónde pasa el electrón es tener certidumbre sobre su posición. Si dejamos que el electrón “continúe en paz” su camino, como no sabemos algo de su posición, éste se comporta como una onda produce interferencia. Es como si el electrón se “enterara de todo”. En probabilidades esto significa: hay dos agujeros, en cada uno hay probabilidades de que el electrón pase, estas probabilidades generan la interferencia; Si se tapara un agujero o si se detectara el electrón, las probabilidades se reducirían a un sólo agujero y ya no habría interferencia, esto equivale a decir: al dejar el cañón, el electrón se divide en muchos electrones llamados electrones fantasmas, estos muchos electrones producen la interferencia, pero si se detecta la posición del sistema, los electrones fantasmas se materializan en un solo electrón rompiendo la interferencia y produciendo lo que se llama colapso de función de onda, es decir: ya no hay onda. También, si el electrón deja de observarse, se desdobla en fantasmas de nuevo.

Aquí se entiende mejor por qué la onda asociada a un cuerpo material es la probabilidad de encontrarlo en un sitio dado: pues si es la probabilidad de encontrarlo, no se conoce su posición, y si no se conoce su posición presenta propiedades ondulatorias.

Otra interpretación: los múltiples mundos

Bohr también dio una interpretación al experimento de la rendija:

Supóngase una partícula la cual tiene dos posibilidades: pasar por el agujero A o por el B, estos agujeros pueden interpretarse como dos mundos; por un mundo la partícula pasa por el agujero A, y por el otro mundo por el B. Nuestro mundo no es alguno de estos dos mundos, sino una “mezcla híbrida” de los dos que genera la interferencia. Pero cuando detectamos por donde pasa el electrón todo se reduce a un sólo mundo: el mundo en donde la partícula pasó por ese agujero, y ya no hay interferencia.

A cada partícula se le puede asociar dos mundos en este caso, pero ¿Cuántas partículas hay en el universo?

Paradoja del gato de Schrödinger

Hacia 1935, Schödinger publicó una paradoja calificada por Einstein como la forma más bonita de mostrar el carácter de incertidumbre en la mecánica cuántica, su carácter incompleto (Einstein nunca aceptó la incertidumbre como una propiedad intrínseca de la naturaleza).

Los fenómenos radiactivos son completamente aleatorios, y sólo pueden expresarse en términos de probabilidades. Supóngase que se tiene una caja en la cual se ha metido un gato, una botella con cianuro, un material radiactivo y un detector de partículas; el experimento está diseñado de forma tal de que el detector esté conectado a la botella, para que cuando reciba radiación del material rompa la botella y mate al gato. Todo el sistema, se monta de forma de que halla un 50% de posibilidad que un núcleo atómico se desintegre; la caja se cierra. No es posible saber si el gato está vivo o no; la única manera de saberlo es si se abre la caja y se observa al gato, pues, como se dijo, la desintegración radiactiva es aleatoria, y para el experimento hay tantas posibilidades de que el gato muera como de que viva.

Así pues, puede interpretarse esto como si el gato tuviera tantas probabilidades de vivir como de morir, esto genera una interferencia, que se rompe cuando se abre la caja (colapso de onda) y las probabilidades se reducen a una. Desde el punto de vista de los otros mundos, existen dos mundos: uno donde el gato está vivo y otro donde está muerto. Pero se está en un mundo híbrido donde el gato está vivo y muerto, esto genera la interferencia; cuando se abre la caja ya sólo se opta por un mundo, o donde el gato vive o donde muere, y se rompe la interferencia.

Suposiciones más importantes

Las suposiciones más importantes de esta teoría son las siguientes:

- Al ser imposible fijar a la vez la posición y el momento de una partícula, se renuncia al concepto de Trayectoria, vital en Mecánica clásica. En vez de eso, el movimiento de una partícula queda regido por una función matemática que asigna, a cada punto del espacio y a cada instante, la Probabilidad de que la partícula descrita se halle en tal posición en ese instante (al menos, en la interpretación de la Mecánica cuántica más usual, la probabilística o Interpretación de Copenhague). A partir de esa función, o Función de ondas, se extraen teóricamente todas las magnitudes del movimiento necesarias.

- Existen dos tipos de evolución temporal, si no ocurre ninguna medida el estado del sistema o Función de onda evolucionan de acuerdo con la Ecuación de Schrödinger, sin embargo, si se realiza una medida sobre el sistema, éste sufre un "salto cuántico" hacia un estado compatible con los valores de la medida obtenida (formalmente el nuevo estado será una Proyección ortogonal del estado original).

- Existen diferencias perceptibles entre los estados ligados y los que no lo están.

- La Energía no se intercambia de forma continua en un estado ligado, sino en forma discreta lo cual implica la existencia de paquetes mínimos de energía llamados cuantos, mientras en los estados no ligados la energía se comporta como un continuo.

Referencias

Enlaces externos

- Introducción a la mecánica cuántica

- Mecánica de Ondas (pwg.gsfc.nasa.gov)

- Experimentos sobre Interferencia de Ondas(Para estudiantes jóvenes)

- El Nacimiento de la Mecánica Cuántica

- Breve Historia de la Física Teórica

- Frecuencias Cuánticas