Varianza

| ||||

Varianza. Se suele emplear en el ámbito de la estadística. Se trata de una palabra impulsada por el matemático y científico inglés Ronald Fisher (1890–1962) y sirve para identificar a la media de las desviaciones cuadráticas de una variable de carácter aleatorio, considerando el valor medio de ésta.

La intención de Ronald Fisher, con esta fórmula era descubrir el valor una variable en un momento concreto con respecto al valor medio o total de dicha variable. Así, la varianza en cierto modo nos ayuda a vaticinar qué es lo que vamos necesitando para el futuro.

La varianza también puede ser muestral y en estos casos lo que hace es analizar datos sobre una comunidad a raíz de una muestra. También se habla de covarianza con la intención de medir la dispersión en este caso de más de una variable.

Sumario

- 1 Teoría de Probabilidad y la Estadística

- 2 Etimología

- 3 Definición

- 4 Fórmula para calcular la varianza

- 5 Propiedades

- 6 Ejemplos

- 7 Varianza muestral

- 8 Algunas aplicaciones de la varianza

- 9 Conclusión

- 10 Para qué sirve la varianza

- 11 Fórmula para calcular la varianza

- 12 Véase también

- 13 Enlace Externo

- 14 Fuente

Teoría de Probabilidad y la Estadística

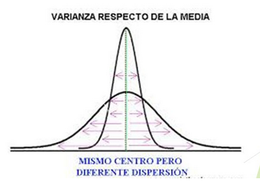

En teoría de probabilidad, la varianza o variancia (que suele representarse como <math>\sigma^2</math>) de una variable aleatoria es una medida de dispersión definida como la esperanza del cuadrado de la desviación de dicha variable respecto a su media. Su unidad de medida corresponde al cuadrado de la unidad de medida de la variable: por ejemplo, si la variable mide una distancia en metros, la varianza se expresa en metros al cuadrado. La varianza tiene como valor mínimo 0. La desviación estándar (raíz cuadrada positiva de la varianza) es una medida de dispersión alternativa, expresada en las mismas unidades que los datos de la variable objeto de estudio.

Hay que tener en cuenta que la varianza puede verse muy influida por los valores atípicos y no se aconseja su uso cuando las distribuciones de las variables aleatorias tienen colas pesadas. En tales casos se recomienda el uso de otras medidas de dispersión más robustas.

Una ventaja de la varianza como medida de dispersión es que es más susceptible de manipulación algebraica que otras medidas de dispersión como la Desviación absoluta esperada; por ejemplo, la varianza de una suma de variables aleatorias no correlacionadas es igual a la suma de sus varianzas. Una desventaja de la varianza para aplicaciones prácticas es que, a diferencia de la desviación estándar, sus unidades difieren de la variable aleatoria, razón por la cual la desviación estándar se reporta más comúnmente como una medida de dispersión una vez terminado el cálculo.

Existen dos conceptos distintos que se denominan "varianza". Uno, como se ha comentado anteriormente, forma parte de una distribución de probabilidad teórica y se define mediante una ecuación. La otra varianza es una característica de un conjunto de observaciones. Cuando la varianza se calcula a partir de observaciones, éstas se suelen medir a partir de un sistema del mundo real. Si están presentes todas las observaciones posibles del sistema, la varianza calculada se denomina varianza poblacional. Sin embargo, normalmente sólo se dispone de un subconjunto, y la varianza calculada a partir de éste se denomina varianza muestral. La varianza calculada a partir de una muestra se considera una estimación de la varianza de toda la población. Existen múltiples formas de calcular una estimación de la varianza de la población, como se explica en la sección siguiente.

Los dos tipos de varianza están estrechamente relacionados. Para véase cómo, considérese que una distribución de probabilidad teórica puede utilizarse como generador de observaciones hipotéticas. Si se genera un número infinito de observaciones utilizando una distribución, entonces la varianza muestral calculada a partir de ese conjunto infinito coincidirá con el valor calculado utilizando la ecuación de la distribución para la varianza.

El término varianza fue acuñado por Ronald Fisher en un artículo publicado en enero de 1919 con el título The Correlation Between Relatives on the Supposition of Mendelian Inheritance.[1]

A continuación se hará un repaso de las fórmulas, hay que tener en cuenta que la fórmula de la varianza para una población (σ2) difiere de la fórmula de la varianza para una muestra (s2), Pero antes de ver la fórmula de la varianza, debemos decir que la varianza en estadística es muy importante. Ya que aunque se trata de una medida sencilla, puede aportar mucha información sobre una variable en concreto.

Etimología

El término varianza fue introducido por primera vez por Ronald Fisher en su artículo de 1918 La correlación entre parientes en el supuesto de herencia mendeliana']:[2]

El gran cuerpo de estadísticas disponibles nos muestra que las desviaciones de una medida humana respecto a su media siguen muy de cerca la Ley Normal de Errores, y, por tanto, que la variabilidad puede medirse uniformemente por la desviación típica correspondiente a la raíz cuadrada del error cuadrático medio. Cuando existen dos causas independientes de variabilidad capaces de producir en una población, por lo demás uniforme, distribuciones con desviaciones típicas <math>\sigma_1</math> y <math>\sigma_2</math>, se comprueba que la distribución, cuando ambas causas actúan conjuntamente, tiene una desviación típica <math>\sqrt{\sigma_1^2 + \sigma_2^2}</math>. Por lo tanto, al analizar las causas de la variabilidad, es conveniente tratar el cuadrado de la desviación típica como medida de la variabilidad. Denominaremos a esta cantidad Varianza...

.

Definición

La varianza de una variable aleatoria <math>X</math> es el valor esperado de las desviación al cuadrado de la media de <math>X</math>, <math>\mu = \operatorname{E}[X]</math>:

- <math> \operatorname{Var}(X) = \operatorname{E}\left[(X - \mu)^2 \right]. </math>

Esta definición abarca variables aleatorias generadas por procesos que son discreta, continua, ninguna de las dos, o mixtos. La varianza también puede considerarse como la covarianza de una variable aleatoria consigo misma:

- <math>\operatorname{Var}(X) = \operatorname{Cov}(X, X).</math>

La varianza también es equivalente al segundo cumulante de una distribución de probabilidad que genera <math>X</math>. La varianza se designa típicamente como <math>\operatorname{Var}(X)</math>, o a veces como <math>V(X)</math> o <math>\mathbb{V}(X)</math>, o simbólicamente como <math>\sigma^2_X</math> o simplemente <math>\sigma^2</math> (pronunciado "sigma al cuadrado"). La expresión para la varianza puede expandirse como sigue:

- <math>\begin{align}

\operatorname{Var}(X) &= \operatorname{E}\left[(X - \operatorname{E}[X])^2\right] \\[4pt] &= \operatorname{E}\left[X^2 - 2X\operatorname{E}[X] + \operatorname{E}[X]^2\right] \\[4pt] &= \operatorname{E}\left[X^2\right] - 2\operatorname{E}[X]\operatorname{E}[X] + \operatorname{E}[X]^2 \\[4pt] &= \operatorname{E}\left[X^2 \right] - \operatorname{E}[X]^2 \end{align}</math>

En otras palabras, la varianza de Plantilla:Mvar es igual a la media del cuadrado de Plantilla:Mvar menos el cuadrado de la media de Plantilla:Mvar. Esta ecuación no debe utilizarse para cálculos que utilizan aritmética de coma flotante, porque sufre de cancelación catastrófica si los dos componentes de la ecuación son similares en magnitud. Para otras alternativas numéricamente estables, véase Algoritmos para calcular la varianza.

Fórmula para calcular la varianza

La unidad de medida de la varianza será siempre la unidad de medida correspondiente a los datos pero elevada al cuadrado. La varianza siempre es mayor o igual que cero. Al elevarse los residuos al cuadrado es matemáticamente imposible que la varianza salga negativa. Y de esa forma no puede ser menor que cero.

Sea <math>X</math> una variable aleatoria con media <math>\mu=\operatorname{E}(X)</math>, se define la varianza de la variable aleatoria <math>X</math>, denotada por <math>\operatorname{Var}(X)</math>, <math>\sigma_X^2</math> o simplemente <math> \sigma^2</math> como

- <math>\operatorname{Var}(X)=\operatorname{E}[ ( X - \mu ) ^ 2]</math>

Desarrollando la definición anterior, se obtiene la siguiente definición alternativa (y equivalente):

- <math>

\begin{align}

\operatorname{Var}(X)

&=\operatorname{E}[ ( X - \mu ) ^ 2 ] \\

&=\operatorname{E}[ ( X ^ 2 - 2X\mu + \mu ^ 2) ] \\

&=\operatorname{E}[ X ^ 2] - 2\mu\operatorname{E}[X] + \mu ^ 2 \\

&=\operatorname{E}[ X ^ 2] - 2\mu ^ 2 + \mu ^ 2 \\

&=\operatorname{E} [ X ^ 2] - \mu ^ 2 \\

&=\operatorname{E} [ X ^ 2] - \operatorname{E}^2 [ X ]

\end{align} </math>

Si una distribución no tiene esperanza, como ocurre con la de Cauchy, tampoco tiene varianza. Existen otras distribuciones que, aun teniendo esperanza, carecen de varianza. Un ejemplo de ellas es la de Pareto cuando su índice <math>k</math> satisface <math> 1 < k \leq 2</math>.

Caso continuo

Si la variable aleatoria <math>X</math> es continua con función de densidad <math>f(x)</math> entonces

- <math>\operatorname{Var}(X)=\int_{R_X}(x-\mu)^2f(x)dx</math>

donde

- <math>\mu=\operatorname{E}[X]=\int_{R_X}xf(x)dx</math>

y las integrales están definidas sobre el soporte de la variable aleatoria <math>X</math>, es decir, <math>R_X</math>.

Caso discreto

Si la variable aleatoria <math>X</math> es discreta con función de probabilidad <math>\operatorname{P}[X=x]</math> entonces

- <math>\operatorname{Var}(X)=\sum_{x\in R_X}(x-\mu)^2\operatorname{P}[X=x]</math>

donde

- <math>\mu=\operatorname{E}[X]=\sum_{x\in R_X}x\operatorname{P}[X=x]</math>

Propiedades

Sean <math>X</math> y <math>Y</math> dos variables aleatorias con varianza finita y <math>a\in\mathbb{R}</math>

- <math>\operatorname{Var}(X) \geq 0</math>

- <math>\operatorname{Var}(a)=0</math>

- <math>\operatorname{Var}(aX)=a^2\operatorname{Var}(X)</math>

- <math>\operatorname{Var}(X+Y)=\operatorname{Var}(X)+\operatorname{Var}(Y)+2\operatorname{Cov}(X,Y)</math>, donde <math>\operatorname{Cov}(X,Y)</math> denota la covarianza de <math>X</math> e <math>Y</math>

- <math>\operatorname{Var}(X+Y)=\operatorname{Var}(X)+\operatorname{Var}(Y)</math> si <math>X</math> y <math>Y</math> son variables aleatorias independientes.

- <math>\operatorname{Var}(Y)=\operatorname{E}(\operatorname{Var}(Y|X))+\operatorname{Var}(\operatorname{E}(Y|X))</math> cálculo de la Varianza por Pitágoras, dónde <math>Y|X</math> es la variable aleatoria condicional <math>Y</math> dado <math>X</math>.

Ejemplos

Al lanzar una moneda podríamos obtener Cara o Cruz.

Vamos a darles los valores Cara = 0 y Cruz = 1 y tenemos una variable aleatoria "X":

Usando notación matemática:

X = {0, 1}

Nota: ¡Podríamos elegir Cara = 100 y Cruz = 150 u otros valores si queremos! Es nuestra elección. Entonces:

- Tenemos un experimento (como lanzar una moneda)

- Damos valores a cada evento.

- El conjunto de valores forman la Variable Aleatoria

Distribución exponencial

Si una variable aleatoria continua <math>X</math> tiene una distribución exponencial con parámetro <math>\lambda</math> entonces su función de densidad está dada por

- <math>f_X(x)=\lambda e^{-\lambda x}</math>

para <math>x\geq0</math>.

No es difícil ver que la media de <math>X</math> es <math>\operatorname{E}[X]=1/\lambda</math>, por lo que para hallar su varianza calculamos

- <math>\begin{align}

\operatorname{Var}(X)

&=\int_0^\infty\left(x-\frac{1}{\lambda}\right)^2\lambda e^{-\lambda x}dx

\end{align}</math>

Después de integrar se puede concluir que

- <math>\operatorname{Var}(X)=\frac{1}{\lambda^2}</math>

Dado perfecto

Un dado de seis caras puede representarse como una variable aleatoria discreta que toma, valores del 1 al 6 con probabilidad igual a 1/6. El valor esperado es (1+2+3+4+5+6)/6 = 3,5. Por lo tanto, su varianza es:

- <math>\sum_{i=1}^6 \tfrac{1}{6} (i - 3,5)^2 = \tfrac{1}{6}\left((-2,5)^2{+}(-1,5)^2{+}(-0,5)^2{+}0,5^2{+}1,5^2{+}2,5^2\right) = \tfrac{1}{6} \cdot 17,50 = \tfrac{35}{12} \approx 2,92\,.</math>

Varianza muestral

En muchas situaciones es preciso estimar la varianza poblacional a partir de una muestra. Si se toma una muestra con reemplazo <math>(x_1,x_2\dots,x_n)</math> de <math>n</math> valores de ella, de entre todos los estimadores posibles de la varianza de la población de partida, existen dos de uso corriente

El primero de ellos

- <math>s_n^2=\frac{1}{n}\sum_{i=1}^n\left(x_i-\bar{x}\right)^2</math>

que puede ser escrito como

- <math>s_n^2 =\frac{1}{n} \sum_{i=1}^{n}x_i^2-\bar{x}^2</math>

pues

- <math>\begin {align}

s_n^2

&=\frac{1}{n}\sum_{i=1}^n\left(x_i-\overline{x}\right)^2 \\

&=\frac{1}{n}\sum_{i=1}^{n}\left(x_i^2-2x_i \overline{x}+\overline{x}^2 \right) \\

&=\frac{1}{n}\sum_{i=1}^{n}x_i^2-\frac{2\overline{x}}{n}\sum_{i=1}^{n}x_i+\overline{x}^2\frac{1}{n}\sum_{i=1}^{n} 1 \\

&=\frac{1}{n}\sum_{i=1}^{n}x_i^2-2\overline{x}^2+\overline{x}^2 \\

&=\frac{1}{n}\sum_{i=1}^{n}x_i^2-\overline{x}^2

\end{align}</math> y el segundo de ellos es

- <math>s^2=\frac{1}{n-1}\sum_{i=1}^n\left(x_i-\overline{x}\right)^2 </math>

que puede ser escrito como

- <math>s^2=\frac{\sum_{i=1}^n x_i^2-n\overline{x}^2}{n-1}</math>

pues

- <math>\begin{align}

s^2 &=\frac {1}{n-1}\sum_{i=1}^n\left(x_i-\overline{x}\right)^2 \\

&=\frac{1}{n-1}\sum_{i=1}^{n}\left(x_i^2-2x_i\overline{x}+\overline{x}^2\right) \\

&=\frac{1}{n-1}\sum_{i=1}^{n}x_i^2-\frac{2\overline{x}}{n-1}\sum_{i=1}^{n}x_i+\frac{\overline{x}^2}{n-1} \sum_{i=1}^{n} 1\\

&=\frac{1}{n-1}\sum_{i=1}^{n}x_i^2-\frac{2\overline{x}n}{n-1}\frac{1}{n}\sum_{i=1}^{n}x_i+\frac{\overline{x}^2n}{n-1}\\

&=\frac{1}{n-1}\sum_{i=1}^{n}x_i^2-\frac{2\overline{x}^2n}{n-1}+\frac{\overline{x}^2n}{n-1}\\

&=\frac{1}{n-1}\sum_{i=1}^{n}x_i^2-\frac{\overline{x}^2n}{n-1}\\

&=\frac{\sum_{i=1}^nx_i^2-n\overline{x}^2}{n-1}

\end{align} </math> A ambos se los denomina varianza muestral, difieren ligeramente y, para valores grandes de <math>n</math>, la diferencia es irrelevante. El primero traslada directamente la varianza de la muestra al de la población y el segundo es un estimador insesgado de la varianza poblacional pues

- <math>

\begin{align}

\operatorname{E}[s^2]

&=\operatorname{E}\left[\frac{1}{n-1} \sum_{i=1}^nx_i^2-\frac{n}{n-1}\overline{x}^2\right] \\

&=\frac{1}{n-1}\left(\sum_{i=1}^n\operatorname{E}[x_i^2]-n\operatorname{E}[\bar{x}^2]\right) \\

&=\frac{1}{n-1}\left(n\operatorname{E}[x_1^2]-n\operatorname{E}[\overline{x}^2]\right) \\

&=\frac{n}{n-1}\left(\operatorname{Var}(x_1)+\operatorname{E}[x_1]^2-\operatorname{Var}(\overline{x})-\operatorname{E}[\overline{x}]^2 \right) \\

&=\frac{n}{n-1}\left(\operatorname{Var}(x_1)+\mu^2-\frac{1}{n}\operatorname{Var}(x_1)-\mu^2\right) \\

&=\frac{n}{n-1}\left(\frac{n-1}{n}~\operatorname{Var}(x_1)\right) \\

& = \operatorname{Var}(x_1) \\ & = \sigma^2 \end{align} </math>

mientras que

- <math>E[s_n^2] = \frac{n-1}{n} \sigma^2</math>

Propiedades de la varianza muestral

Como consecuencia de la igualdad <math> \operatorname{E}(s^2)=\sigma^2</math>, <math> s^2 </math> es un estadístico insesgado de <math>\sigma^2</math>. Además, si se cumplen las condiciones necesarias para la ley de los grandes números, s2 es un estimador consistente de <math>\sigma^2</math>.

Más aún, cuando las muestras siguen una distribución normal, por el teorema de Cochran, <math>s^2</math> tiene la distribución chi-cuadrado:

- <math>

n\frac{s^2}{\sigma^2}\sim\chi^2_{n-1}. </math>

Interpretaciones de la varianza muestral

Dejamos tres fórmulas equivalentes para el cálculo de la varianza muestral <math>s_n </math>

- <math>s_n^2 = \frac 1n \sum_{i=1}^n \left(y_i - \overline{y} \right)^ 2 = \left(\frac{1}{n} \sum_{i=1}^{n}y_i^2\right) - \overline{y}^2=

\frac{1}{n^2} \sum_{i<j}\left(y_i-y_j\right)^2</math>

Esta última igualdad tiene interés para interpretar los estimadores <math>s^2 </math> y <math>s_n^2 </math>, pues si se quiere evaluar la desviación de unos datos o sus diferencias, se puede optar por calcular el promedio de los cuadrados de las diferencias de cada par de datos:

- <math>2s_n^2= \frac { \sum_{\left(i\leqslant n, j \leqslant n \right)} \left(y_i - y_j \right)^ 2}{n^2}</math>. Nótese que el número de sumandos es <math> n^2</math>.

O se puede considerar el promedio de los cuadrados de las diferencias de cada par de datos sin tener en cuenta cada dato consigo mismo, ahora el número de sumandos es <math> n\left(n - 1\right)</math>.

- <math>2s^2 = \frac {\sum_{i\neq j} \left(y_i - y_j \right)^ 2}{n\left(n - 1\right)}</math>

Algunas aplicaciones de la varianza

Las aplicaciones estadísticas del concepto de la varianza son incontables. Las siguientes son solo algunas de las principales:

- Los estimadores eficientes. Son aquellos cuya esperanza es el verdadero valor del parámetro y, además, tienen una mínima varianza. De este modo, hacemos lo más pequeño posible el riesgo de que lo que extraemos de una muestra se aparte demasiado del verdadero valor del parámetro.

- Los estimadores consistentes. Son aquellos que, a medida que crece el tamaño de la muestra, tienden a tener una varianza de cero. Por lo tanto, con muestras grandes, la estimación tiende a desviarse muy poco del verdadero valor.

- En la distribución normal, la varianza (su raíz cuadrada, la desviación típica) es uno de los parámetros. La campana de Gauss tiende a ser más alta y estrecha a medida que la varianza disminuye.

- En modelos de regresión, hablamos de homocedasticidad cuando la varianza del error es constante a lo largo de sus observaciones. Por ejemplo, en una regresión simple, vemos una nube de puntos en la que la dispersión de los puntos alrededor de la recta o curva estimada se mantiene constante.

- El análisis de la varianza (ANOVA) permite comparar diferentes grupos y ver los factores que influyen en ellos.

- La desigualdad de Chebyshev nos permite acotar en qué medida es probable que una variable aleatoria se separe de su esperanza matemática en proporción a su desviación típica (raíz cuadrada de la varianza).

Conclusión

En el análisis de varianzas se estudian las diferencias significativas entre dos o más medias de una muestra. Este análisis se conoce comúnmente como ANOVA y nos permite determinar también si esas medias provienen de una misma población (puede ser el número total de empleados de una empresa), o si las medias de dos poblaciones son iguales.

Por otro lado, la varianza al igual que la desviación estándar son muy sensibles a los valores atípicos, estos son los valores que se alejan mucho de la media o que son muy distintos a esta.

Para que estas medidas no se vean tan afectadas, estos valores atípicos pueden obviarse a la hora de realizar los análisis e incluso los cálculos. También pueden emplearse otras medidas de dispersión que son más útiles en estos casos.

En el caso de analizar el riesgo de una inversión, se tienen en cuenta dos aspectos importantes, uno es el rendimiento invertido y otro el esperado de acuerdo a la inversión realizada. Como ya se mencionó, se puede utilizar la varianza para analizar este riesgo.

Para qué sirve la varianza

Al proponer la utilización de la varianza, Ronald Fisher mencionó que esta serviría para saber y considerar el valor medio de una variable. Tal es así que la varianza fue creada para determinar si las diferencias que existen entre las medias de muestreo exponen las diferencias que hay entre los valores medios.

De esta manera, se identifica el valor por medio de una raíz cuadrada que permite saber cuán dificultoso es el margen de errores y, asimismo, realizar un plan específico y exitoso.

La varianza es utilizada por empresas e industrias como método de prevención y visualización hacia el futuro.

Fórmula para calcular la varianza

Donde:

- X: variable sobre la que se pretenden calcular la varianza

- xi: observación número i de la variable X. i puede tomará valores entre 1 y n.

- n: número de observaciones.

- x̄: Es la media de la variable X.

O lo que es lo mismo:

Véase también

- Desviación típica o desviación estándar

- Esperanza matemática o valor esperado

- Covarianza

- Análisis de varianza

Enlace Externo

- Wikipedia.Disponible en:[1]

Fuente

- Enciclopediaeconomica.Disponible en:[2]. Consultado el 10 de marzo de2021

- Economiasimple. Disponible en:[3]. Consultado el 10 de marzo de2021

- Definición. Disponible en:[4]. Consultado el 10 de marzo de2021 ]